Η κυριαρχία της ΑΙ: Οι νέοι κανόνες του πολέμου

Διαβάζεται σε 10'

Οι στρατιωτικοί διοικητές ελπίζουν σε μια ψηφιακά ενισχυμένη δύναμη, αλλά μήπως τα αυτόνομα όπλα σημαίνουν ότι κινδυνεύουν να χάσουν τον έλεγχο;

- 19 Νοεμβρίου 2025 06:14

Καλώς ορίσατε ξανά στο The State of AI, μια νέα συνεργασία μεταξύ των Financial Times και του MIT Technology Review. Για τις επόμενες τέσσερις εβδομάδες, συγγραφείς και από τις δύο εκδόσεις θα συζητούν μια πτυχή της παραγωγικής επανάστασης της Τεχνητής Νοημοσύνης που αναδιαμορφώνει την παγκόσμια ισχύ.

Την περασμένη εβδομάδα, εξετάσαμε την ενεργειακή κρίση. Αυτή την εβδομάδα, η Helen Warrell, ερευνητική δημοσιογράφος των FT και πρώην συντάκτρια άμυνας και ασφάλειας, και ο James O’Donnell, έμπειρος δημοσιογράφος που καλύπτει θέματα Τεχνητής Νοημοσύνης στο MIT Technology Review, εξετάζουν τα ηθικά διλήμματα και τα οικονομικά κίνητρα γύρω από τη χρήση της Τεχνητής Νοημοσύνης από τον στρατό.

Ο James και η Helen θα δώσουν συνέντευξη σχετικά με τις ιδέες τους στο podcast News Briefing των FT την επόμενη εβδομάδα – μπορείτε να βρείτε τα επεισόδια εδώ. Και μπορείτε να ακούσετε τους John Thornhill και Caiwei Chen, οι οποίοι έγραψαν το πρώτο ενημερωτικό δελτίο για την κόντρα ΗΠΑ και Κίνας, να δίνουν συνέντευξη στο podcast Rachman Review των Financial Times

Η Helen Warrell γράφει:

Είναι Ιούλιος του 2027, και η Κίνα είναι έτοιμη να εισβάλει στην Ταϊβάν. Αυτόνομα drones με δυνατότητες στόχευσης μέσω AI είναι έτοιμα να υπερφαλαγγίσουν τις αεροπορικές άμυνες του νησιού, ενώ μια σειρά από κυβερνοεπιθέσεις με χρήση AI κόβουν την παροχή ενέργειας και επικοινωνίας.

Παράλληλα, μια τεράστια καμπάνια παραπληροφόρησης που διεξάγεται από μια φιλοκινεζική “γραμμή παραγωγής” memes, που τροφοδοτείται από τεχνητή νοημοσύνη εξαπλώνεται στα παγκόσμια μέσα κοινωνικής δικτύωσης, αποδυναμώνοντας τις διαμαρτυρίες για την επιθετικότητα του Πεκίνου.

Σενάρια όπως αυτό έχουν φέρει δυστοπικό τρόμο στη συζήτηση για τη χρήση της AI στον πόλεμο. Οι στρατιωτικοί διοικητές ελπίζουν σε μια ψηφιακά ενισχυμένη δύναμη που είναι ταχύτερη και ακριβέστερη από την ανθρώπινη εμπλοκή στη μάχη. Υπάρχουν όμως φόβοι ότι, καθώς η Τεχνητή Νοημοσύνη αναλαμβάνει έναν ολοένα και πιο κεντρικό ρόλο, οι ίδιοι αυτοί διοικητές θα χάσουν τον έλεγχο μιας σύγκρουσης που κλιμακώνεται πολύ γρήγορα και στερείται ηθικής ή νομικής εποπτείας.

Ο Χένρι Κίσινγκερ, ο πρώην υπουργός Εξωτερικών των ΗΠΑ, πέρασε τα τελευταία χρόνια της ζωής του προειδοποιώντας για την επερχόμενη καταστροφή που προκαλείται από τον πόλεμο που καθοδηγείται από την Τεχνητή Νοημοσύνη.

Η κατανόηση και ο μετριασμός αυτών των κινδύνων αποτελεί στρατιωτική προτεραιότητα – κάποιοι θα έλεγαν πως είναι μια “στιγμή Oppenheimer” – της εποχής μας. Μια αναδυόμενη συναίνεση στη Δύση είναι ότι οι αποφάσεις σχετικά με την ανάπτυξη πυρηνικών όπλων δεν πρέπει να ανατίθενται στην Τεχνητή Νοημοσύνη.

Ο Γενικός Γραμματέας του ΟΗΕ, Αντόνιο Γκουτέρες, προχώρησε ένα βήμα παραπέρα, ζητώντας την πλήρη απαγόρευση των πλήρως αυτόνομων θανατηφόρων οπλικών συστημάτων. Είναι απαραίτητο η νομοθεσία να συμβαδίζει με την εξελισσόμενη τεχνολογία. Αλλά μέσα στον ενθουσιασμό που τροφοδοτείται από την επιστημονική φαντασία, είναι εύκολο να χάσει κανείς την αίσθηση του τι είναι πραγματικά εφικτό. Όπως επισημαίνουν οι ερευνητές του Belfer Center του Χάρβαρντ, οι αισιόδοξοι για την Τεχνητή Νοημοσύνη συχνά υποτιμούν τις προκλήσεις της χρήσης πλήρως αυτόνομων οπλικών συστημάτων. Είναι απολύτως πιθανό οι δυνατότητες της Τεχνητής Νοημοσύνης στη μάχη να υπερεκτιμώνται.

Ο καθηγητής Anthony King, βασικός υποστηρικτής αυτού του επιχειρήματος, υποστηρίζει ότι αντί να αντικαταστήσει τους ανθρώπους, η Τεχνητή Νοημοσύνη θα χρησιμοποιηθεί για τη βελτίωση της στρατιωτικής διορατικότητας. Ακόμα κι αν ο χαρακτήρας του πολέμου αλλάζει και η τεχνολογία εξ αποστάσεως βελτιώνει τα συστήματα όπλων, επιμένει: «Η πλήρης αυτοματοποίηση του ίδιου του πολέμου είναι απλώς μια ψευδαίσθηση».

Από τις τρεις τρέχουσες περιπτώσεις στρατιωτικής χρήσης της Τεχνητής Νοημοσύνης, καμία δεν βασίζεται στην πλήρη αυτονομία. Αναπτύσσεται για σχεδιασμό και εφοδιασμό, κυβερνοπόλεμο (σε δολιοφθορές, κατασκοπεία, hacking και επιχειρήσεις πληροφόρησης) και, στην πιο αμφιλεγόμενη διάσταση, σε στόχευση όπλων. Η τελευταία διάσταση χρησιμοποιείται ήδη στα πεδία των μαχών της Ουκρανίας και της Γάζας.

Τα στρατεύματα του Κιέβου χρησιμοποιούν λογισμικό Τεχνητής Νοημοσύνης για να κατευθύνουν μη επανδρωμένα αεροσκάφη (drones) ικανά να αποφεύγουν τη ρωσική αναχαίτιση καθώς πλησιάζουν σε ευαίσθητες τοποθεσίες. Οι Ισραηλινές Ένοπλες Δυνάμεις έχουν αναπτύξει ένα σύστημα υποστήριξης με τη βοήθεια της Τεχνητής Νοημοσύνης, γνωστό ως «Lavender», το οποίο έχει βοηθήσει στον εντοπισμό περίπου 37.000 πιθανών ανθρώπινων στόχων εντός της Γάζας.

Υπάρχει σαφής κίνδυνος η βάση δεδομένων Lavender να αναπαράγει τις προκαταλήψεις των δεδομένων με τα οποία εκπαιδεύεται. Αλλά και το στρατιωτικό προσωπικό φέρει προκαταλήψεις. Ένας Ισραηλινός αξιωματικός των μυστικών υπηρεσιών που χρησιμοποίησε τη βάση δεδομένων Lavender ισχυρίστηκε ότι είχε μεγαλύτερη εμπιστοσύνη στην ακρίβεια ενός “στατιστικού μηχανισμού” παρά σε έναν θλιμμένο στρατιώτη.

Οι αισιόδοξοι για την τεχνολογία στην οποία βασίζονται τα όπλα τεχνητής νοημοσύνης αρνούνται ακόμη και ότι χρειάζονται συγκεκριμένοι νέοι έλεγχοι για τη διαχείριση των δυνατοτήτων τους. Ο Keith Dear, πρώην αξιωματικός του βρετανικού στρατού που τώρα διευθύνει την εταιρεία στρατηγικών προβλέψεων Cassi AI, λέει ότι οι υπάρχοντες νόμοι είναι παραπάνω από επαρκείς. «Φροντίζεις να μην υπάρχει τίποτα στα δεδομένα εκπαίδευσης που θα μπορούσε να κάνει το σύστημα να ξεφύγει… όταν είσαι σίγουρος, το αναπτύσσεις – και εσύ, ο ανθρώπινος διοικητής, είσαι υπεύθυνος για οτιδήποτε πάει στραβά».

Είναι μια ενδιαφέρουσα σκέψη ότι μέρος του φόβου και του σοκ σχετικά με τη χρήση της Τεχνητής Νοημοσύνης στον πόλεμο μπορεί να προέρχεται από εκείνους που δεν είναι εξοικειωμένοι με τους βάναυσους αλλά ρεαλιστικούς στρατιωτικούς κανόνες. Τι πιστεύεις, James; Μήπως κάποια αντίθεση στην Τεχνητή Νοημοσύνη στον πόλεμο αφορά λιγότερο τη χρήση αυτόνομων συστημάτων και είναι στην πραγματικότητα ένα επιχείρημα κατά του ίδιου του πολέμου;

Ο James O’Donnell απαντά

Γειά σου Helen,

Ένα πράγμα που έχω παρατηρήσει είναι ότι έχει υπάρξει μια δραστική αλλαγή στις στάσεις των εταιρειών τεχνητής νοημοσύνης σχετικά με τις στρατιωτικές εφαρμογές των προϊόντων τους. Στις αρχές του 2024, η OpenAI απαγόρευσε κατηγορηματικά τη χρήση των εργαλείων της για πολεμικές επιχειρήσεις, αλλά μέχρι το τέλος του έτους είχε υπογράψει συμφωνία με την Anduril (αμερικανική εταιρεία αμυντικής τεχνολογίας) για να βοηθήσει στην εξουδετέρωση drones στο πεδίο της μάχης.

Αυτό το βήμα – όχι ένα πλήρως αυτόνομο όπλο, σίγουρα, αλλά σε μεγάλο βαθμό μια εφαρμογή της Τεχνητής Νοημοσύνης στο πεδίο της μάχης – σηματοδότησε μια δραστική στροφή στο πόσο οι εταιρείες τεχνολογίας θα μπορούσαν να συνδεθούν δημόσια με την άμυνα.

Τι συνέβη στην πορεία; Καταρχάς, είναι η διαφημιστική εκστρατεία. Μας λένε ότι η Τεχνητή Νοημοσύνη δεν θα φέρει μόνο υπερ-νοημοσύνη και επιστημονικές ανακαλύψεις, αλλά στον τομέα της εθνικής ασφάλειας υπόσχεται επίσης να κάνει τον πόλεμο πιο οξύ, πιο ακριβή και λιγότερο επιρρεπή σε ανθρώπινα λάθη. Μίλησα με Αμερικανούς πεζοναύτες, για παράδειγμα, οι οποίοι δοκίμασαν έναν τύπο Τεχνητής Νοημοσύνης ενώ περιπολούσαν τον νότιο Ειρηνικό, ο οποίος διαφημιζόταν ότι αναλύει ξένες πληροφορίες πιο γρήγορα από ό,τι θα μπορούσε ένας άνθρωπος.

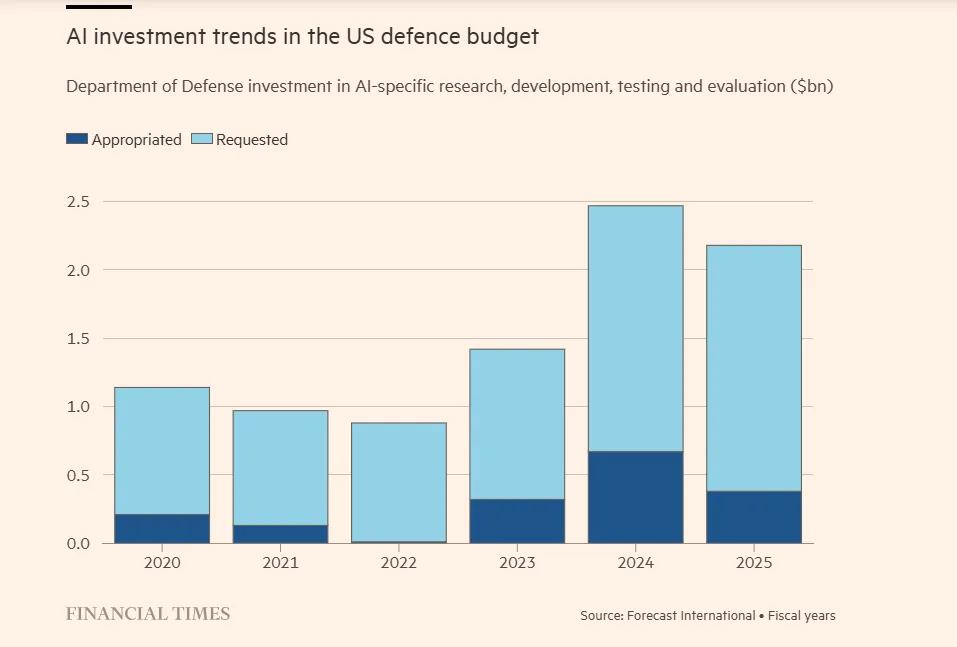

Δεύτερον, τα χρήματα μετράνε. Η OpenAI και άλλοι πρέπει να αρχίσουν να ανακτούν κάποια από τα απίστευτα ποσά μετρητών που ξοδεύουν για την εκπαίδευση και τη λειτουργία αυτών των μοντέλων. Και λίγοι έχουν πιο πλούσιες τσέπες από το Πεντάγωνο. Οι επικεφαλής άμυνας της Ευρώπης φαίνεται να είναι πρόθυμοι να διαθέσουν και αυτοί χρήματα. Εν τω μεταξύ, το ποσό της χρηματοδότησης επιχειρηματικών κεφαλαίων για την αμυντική τεχνολογία φέτος είναι ήδη διπλάσιο από ό,τι ήταν ολόκληρο το 2024, ελπίζοντας να επωφεληθούν από τη νεοαποκτηθείσα προθυμία των ενόπλων δυνάμεων να αγοράσουν από νεοσύστατες επιχειρήσεις.

Πιστεύω ότι η αντίθεση στον πόλεμο με τεχνητή νοημοσύνη χωρίζεται σε μερικά στρατόπεδα, ένα από τα οποία απλώς απορρίπτει την ιδέα ότι η ακριβέστερη στόχευση (αν είναι όντως ακριβέστερη) θα σημαίνει λιγότερα θύματα ή μάλλον, σε περισσότερους πολέμους. Σκεφτείτε την πρώτη εποχή του πολέμου με drones στο Αφγανιστάν. Καθώς οι επιθέσεις με μη επανδρωμένα αεροσκάφη έγιναν φθηνότερες στην εφαρμογή τους, μπορούμε πραγματικά να πούμε ότι μειώθηκε η καταστροφή, ή απλώς επέτρεψε περισσότερη καταστροφή ανά δολάριο;

Αλλά το δεύτερο στρατόπεδο κριτικής (και τώρα φτάνω επιτέλους στο ερώτημά σας) προέρχεται από ανθρώπους που γνωρίζουν καλά την πραγματικότητα του πολέμου, αλλά έχουν πολύ συγκεκριμένα παράπονα σχετικά με τους θεμελιώδεις περιορισμούς της τεχνολογίας. Η Missy Cummings, για παράδειγμα, είναι πρώην πιλότος μαχητικών αεροσκαφών του Πολεμικού Ναυτικού των ΗΠΑ, η οποία τώρα είναι καθηγήτρια μηχανικής και επιστήμης υπολογιστών στο Πανεπιστήμιο George Mason. Έχει εκφράσει ανοιχτά την πεποίθησή της ότι τα μεγάλα γλωσσικά μοντέλα είναι επιρρεπή σε τεράστια λάθη σε στρατιωτικά περιβάλλοντα.

Η συνήθης απάντηση σε αυτή την ανησυχία είναι ότι τα αποτελέσματα της Τεχνητής Νοημοσύνης ελέγχονται από ανθρώπους. Αλλά αν ένα μοντέλο Τεχνητής Νοημοσύνης βασίζεται σε χιλιάδες δεδομένα εισόδου για το συμπέρασμά του, μπορεί όντως αυτό το συμπέρασμα να ελεγχθεί από ένα άτομο;

Οι εταιρείες τεχνολογίας δίνουν εξαιρετικά μεγάλες υποσχέσεις σχετικά με το τι μπορεί να κάνει η Τεχνητή Νοημοσύνη σε αυτές τις εφαρμογές υψηλού ρίσκου, ενώ παράλληλα η πίεση για την εφαρμογή τους είναι τεράστια. Για μένα, αυτό σημαίνει ότι ήρθε η ώρα για περισσότερο σκεπτικισμό, όχι λιγότερο.

Η Helen Warrell απαντά

Γειά σου James,

Θα πρέπει σίγουρα να συνεχίσουμε να αμφισβητούμε την ασφάλεια και την εποπτεία των συστημάτων πολέμου που λειτουργούν με τεχνητή νοημοσύνη – και να ζητάμε από τους πολιτικούς ηγέτες να λογοδοτήσουν σε αυτόν τον τομέα. Θα πρέπει επίσης να επιδείξουμε κάποιο σκεπτικισμό σε αυτό που δικαίως περιγράφετε ως τις «εξαιρετικά μεγάλες υποσχέσεις» που δίνουν ορισμένες εταιρείες σχετικά με το τι θα μπορούσε να πετύχει η τεχνητή νοημοσύνη στο πεδίο της μάχης. Θα υπάρξουν τόσο ευκαιρίες όσο και κίνδυνοι σε αυτό που προσφέρει στον στρατό μια σχετικά νεοσύστατη (και ακμάζουσα) σκηνή αμυντικής τεχνολογίας. Ο κίνδυνος είναι ότι, με την ταχύτητα και τη μυστικότητα ενός ανταγωνισμού εξοπλισμών με όπλα τεχνητής νοημοσύνης, αυτές οι αναδυόμενες δυνατότητες ίσως να μην πάρουν την προσοχή και την συζήτηση που τόσο απεγνωσμένα χρειάζονται.

Περαιτέρω ανάγνωση

- Ο Michael C. Horowitz, διευθυντής του Perry World House στο Πανεπιστήμιο της Πενσυλβάνια, εξηγεί την ανάγκη για υπευθυνότητα εκ προοιμίου στον σχεδιασμό και την ανάπτυξη στρατιωτικών συστημάτων τεχνητής νοημοσύνης σε αυτό το άρθρο γνώμης των Financial Times.

- Το τεχνολογικό podcast των FT διερωτάται τι μπορεί να μας πει το οικοσύστημα αμυντικής τεχνολογίας του Ισραήλ για το μέλλον του πολέμου.

- Αυτό το άρθρο του MIT Technology Review αναλύει πώς το OpenAI ολοκλήρωσε τη στροφή του προς την τεχνητή νοημοσύνη στο πεδίο της μάχης.

- Το MIT Technology Review αποκαλύπτει πώς οι Αμερικανοί στρατιώτες χρησιμοποιούν την γενετική τεχνητή νοημοσύνη για να βοηθήσουν στην αναζήτηση χιλιάδων πληροφοριών ανοιχτού κώδικα.

© The Financial Times Limited 2026. Όλα τα δικαιώματα διατηρούνται. Απαγορεύεται η αναδιανομή, αντιγραφή ή τροποποίηση με οποιονδήποτε τρόπο. Το NEWS 24/7 φέρει την αποκλειστική ευθύνη για την παρούσα μετάφραση και η Financial Times Limited δεν αποδέχεται καμία ευθύνη για την ακρίβεια ή την ποιότητα της μετάφρασης.